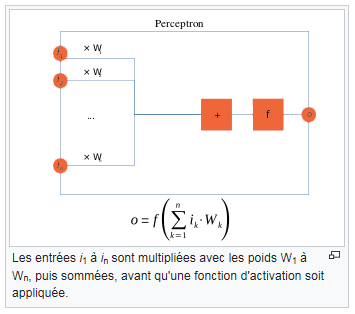

Single-Layer Neural Network (Perceptron)

| Le perceptron est un algorithme d'apprentissage supervisé de classifieurs binaires (c'est-à-dire séparant deux classes). Il a été inventé en 1957 par Frank Rosenblatt au laboratoire d'aéronautique de l'université Cornell. C'est un modèle inspiré des théories cognitives de Friedrich Hayek et de Donald Hebb. Il s'agit d'un neurone formel muni d'une règle d'apprentissage qui permet de déterminer automatiquement les poids synaptiques de manière à séparer un problème d'apprentissage supervisé. Si le problème est linéairement séparable, un théorème assure que la règle du perceptron permet de trouver une séparatrice entre les deux classes. |  |

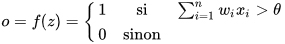

La sortie o résulte alors de l'application de la fonction de Heaviside au potentiel post-synaptique

avec :

avec :

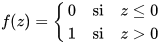

Cette fonction non linéaire est appelée fonction d'activation.

Une alternative couramment employée est

, la tangente hyperbolique.

, la tangente hyperbolique.